Фото: canva

Коллектив национального государства надеется, что остальной мир последует его примеру.

Пока американские законодатели проводят очередные слушания в Конгрессе об опасностях, связанных с алгоритмической предвзятостью в социальных сетях, Европейская комиссия (в основном исполнительная ветвь ЕС) представила широкую нормативную базу, которая в случае принятия может иметь глобальные последствия для будущего развития ИИ.

Это не первая попытка Комиссии направить рост и развитие этой новой технологии. После обширных встреч с группами защиты интересов и другими заинтересованными сторонами Европейская комиссия выпустила в 2018 году как первую Европейскую стратегию по ИИ, так и Скоординированный план по ИИ. Затем в 2019 году были приняты Руководящие принципы для заслуживающего доверия ИИ, а затем в 2020 году Белая книга Комиссии по ИИ и доклад о последствиях искусственного интеллекта, Интернета вещей и робототехники для безопасности и ответственности. Так же, как и в своем амбициозном плане Общего регламента защиты данных (GDPR) в 2018 году, Комиссия стремится установить базовый уровень общественного доверия к технологии на основе строгих мер защиты пользователей и конфиденциальности данных, а также защиты от ее потенциального злоупотребления.

«Искусственный интеллект должен быть не самоцелью, а инструментом, который должен служить людям с конечной целью повышения благосостояния людей. Правила для ИИ, доступные на рынке Союза или иным образом влияющие на граждан Союза, должны, таким образом, ставить людей в центр (быть ориентированными на человека), чтобы они могли доверять тому, что технология используется безопасным и совместимым с законом способом, включая уважение основных прав », — включила Комиссия в свой проект постановления. «В то же время такие правила для ИИ должны быть сбалансированными, соразмерными и не должны излишне ограничивать или препятствовать технологическому развитию. Это особенно важно, потому что, хотя ИИ уже присутствует во многих аспектах повседневной жизни людей, невозможно предвидеть все возможные варианты его использования или применения, которые могут произойти в будущем».

Действительно, системы искусственного интеллекта уже повсеместны в нашей жизни — от рекомендательных алгоритмов, которые помогают нам решать, что смотреть в Netflix и на кого подписываться в Twitter, до цифровых помощников в наших телефонах и систем помощи водителю, которые следят за нами за дорогой (или нет), когда мы едем.

«Европейская комиссия в очередной раз решительно выступила против новых технологий, точно так же, как они сделали с конфиденциальностью данных через GDPR», — сказала Engadget д-р Брэнди Ноннеке, директор лаборатории политик CITRIS в Калифорнийском университете в Беркли. «Предлагаемое регулирование весьма интересно тем, что решает проблему с помощью подхода, основанного на оценке риска», аналогичного тому, который используется в предлагаемой Канадской нормативной базе ИИ.»

Эти новые правила разделят усилия ЕС по разработке ИИ на четырехуровневую систему — минимальный риск, ограниченный риск, высокий риск и полностью запрещены — в зависимости от их потенциального вреда для общественного блага.

«Рамки риска, в которых они работают, на самом деле связаны с риском для общества, тогда как всякий раз, когда вы слышите о риске [в США], это в значительной степени риск в контексте вроде: «Каковы мои обязательства, каковы мои риски? », — Дженнифер Кинг, научный сотрудник Института искусственного интеллекта, ориентированного на человека, при Стэнфордском университете, рассказала Engadget. «И каким-то образом, если это включает права человека как часть этого риска, тогда он включается, но в той степени, в которой это может быть вынесено вовне, это не включается».

Абсолютно запрещенное использование технологии будет включать в себя любые приложения, которые манипулируют поведением человека, чтобы обойти свободную волю пользователей — особенно те, которые используют уязвимости определенной группы людей из-за их возраста, физических или умственных недостатков, а также системы биометрической идентификации в режиме «реального времени», которые позволяют правительствам подсчитывать социальные баллы. Это прямой намек на систему социального кредитования, и, учитывая, что эти правила все еще теоретически будут регулировать технологии, которые влияют на граждан ЕС, независимо от того, находились ли эти люди физически в границах ЕС, может привести к некоторым интересным международным инцидентам в ближайшем будущем.

«Предстоит проделать большую работу по внедрению руководства», - отметил Кинг.

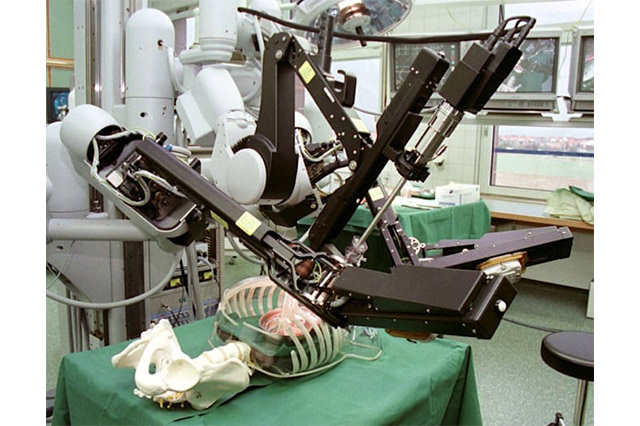

С другой стороны, приложения с высоким уровнем риска определяются как любые продукты, в которых ИИ «предназначен для использования в качестве компонента безопасности продукта» или ИИ сам является компонентом безопасности (подумайте, функция предотвращения столкновений на вашем автомобиле). Кроме того, приложения ИИ, предназначенные для любого из 8 конкретных рынков, включая критическую инфраструктуру, образование, юридические/судебные вопросы и найм сотрудников, считаются частью категории высокого риска. Они могут поступать на рынок, но перед поступлением в продажу к ним предъявляются строгие нормативные требования, такие как требование к разработчику ИИ соблюдать правила ЕС на протяжении всего жизненного цикла продукта, обеспечивать строгие гарантии конфиденциальности. К сожалению, это означает, что в обозримом будущем не будет полностью автономных робохирургов.

«Я понял, что европейцы, похоже, предполагают надзор -— я не знаю, будет ли это перегибом говорить от колыбели до могилы», — сказал Кинг. «Но, похоже, есть ощущение, что необходим постоянный мониторинг и оценка, особенно гибридные системы». Частью этого надзора является стремление ЕС создать нормативные «песочницы» для ИИ, которые позволят разработчикам создавать и тестировать системы с высоким риском в реальных условиях, но без последствий для реального мира.

Эти «песочницы», в которых все неправительственные организации — а не только те, которые достаточно велики для того, чтобы иметь независимые бюджеты на НИОКР — могут свободно разрабатывать свои системы ИИ под бдительным взором регулирующих органов ЕС, «предназначены для предотвращения такого сдерживающего эффекта, который наблюдался в результате GDPR, который привел к 17% увеличению концентрации рынка после его введения, — отметил Джейсон Пилкингтон. «Но неясно, смогут ли они достичь этой цели».

ЕС также планирует создать Европейский совет по ИИ для контроля за соблюдением требований.

Ноннеке также отмечает, что многие области, затрагиваемые этими правилами высокого риска, совпадают с теми, которые академические исследователи и журналисты изучали в течение многих лет.

«Я думаю, что это действительно подчеркивает важность эмпирических исследований и журналистских расследований, чтобы наши законодатели могли лучше понять, каковы риски этих систем ИИ, а также каковы преимущества этих систем», — сказала она. «Одна область, к которой эти правила явно не применяются, — это ИИ, созданный специально для военных операций, поэтому ожидайте роботов-убийц.»

К приложениям с ограниченным риском относятся такие вещи, как чат-боты на веб-сайтах сервисов или с содержанием deepfake. В этих случаях разработчик ИИ просто должен заранее сообщить пользователям, что они будут взаимодействовать с машиной, а не с другим человеком или даже собакой. А для продуктов с минимальным риском, таких как ИИ в видеоиграх и на самом деле подавляющее большинство приложений, которые ожидает увидеть ЕС, правила не требуют каких-либо особых ограничений или дополнительных требований, которые необходимо выполнить перед выходом на рынок.

И если какая-либо компания или разработчик осмелится проигнорировать эти правила, они обнаружат, что их нарушение влечет за собой крупный штраф, который можно измерить в процентах от ВВП. В частности, штрафы за несоблюдение требований могут составлять до 30 миллионов евро или 4% от глобального годового дохода организации, в зависимости от того, что больше.

«Для нас на европейском уровне важно передать очень сильное послание и установить стандарты с точки зрения того, как далеко должны развиваться эти технологии», — сказал Bloomberg Драгос Тудораче, член Европейского парламента и глава комитета по ИИ. «Создание нормативно-правовой базы вокруг них — необходимость, и хорошо, что Европейская комиссия идет в этом направлении».

Еще неизвестно, последует ли в этом направлении остальной мир за Брюсселем. Учитывая то, как в настоящее время правила определяют, что такое ИИ — и это делается в очень общих чертах — мы, вероятно, можем ожидать, что этот закон повлияет почти на все аспекты глобального рынка и каждый сектор мировой экономики, а не только в цифровой сфере. Конечно, эти правила должны будут пройти через строгий (часто вызывающий споры) парламентский процесс, на завершение которого могут потребоваться годы, прежде чем они будут приняты.

Источник: Engadget

Перевод: Айнур Искаккова