Новый процессор должен снизить издержки Azure и повысить эффективность ИИ-сервисов, передает DKNews.kz.

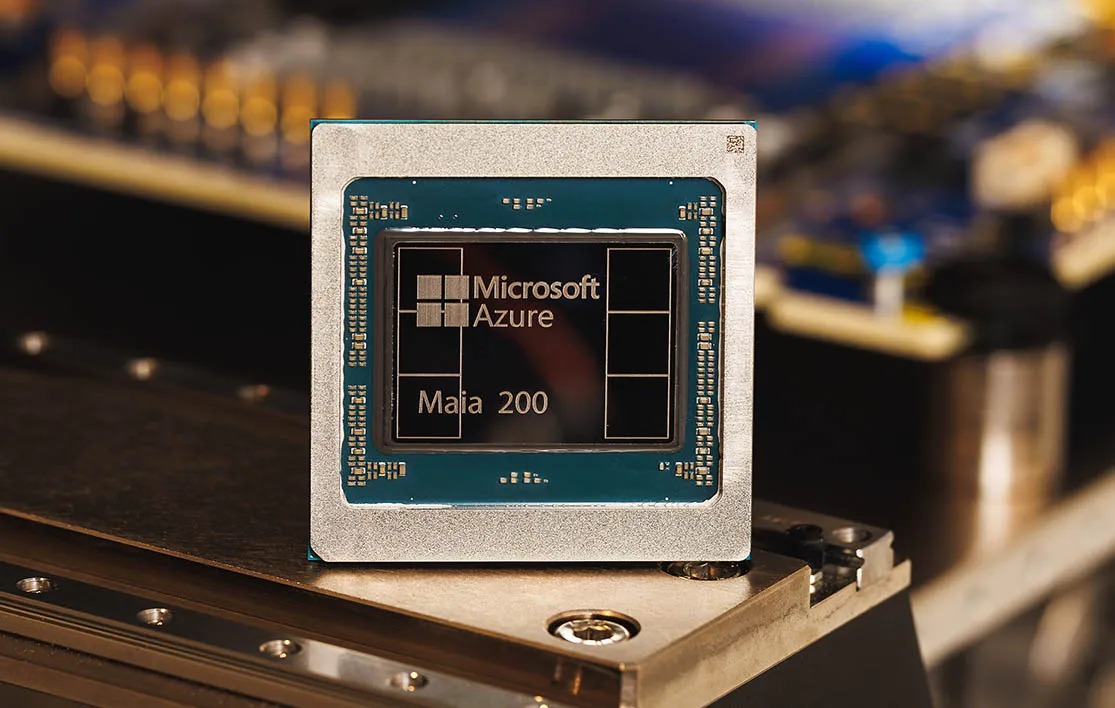

Microsoft сделала очередной шаг к технологической независимости в сфере искусственного интеллекта. Компания представила ИИ-чип второго поколения Maia 200, который становится важным элементом стратегии по повышению эффективности облачных сервисов и снижению зависимости от решений Nvidia. Об этом сообщает Bloomberg.

Речь не идет о резком отказе от GPU Nvidia, но Microsoft все отчетливее показывает: в эпоху дефицита вычислительных мощностей собственные чипы становятся вопросом устойчивости бизнеса.

Где уже работает Maia 200

Производством чипа занимается Taiwan Semiconductor Manufacturing Co (TSMC). Поставки Maia 200 уже начались - первые партии направлены в дата-центры Microsoft в штате Айова. В дальнейшем компания планирует расширить размещение оборудования в районе Финикса.

В понедельник Microsoft также открыла для разработчиков доступ к программному обеспечению управления Maia, что позволяет ускорить внутреннее тестирование и оптимизацию. При этом сроки появления серверов на базе нового чипа в облаке Azure для внешних клиентов пока не раскрываются.

Для чего Microsoft использует новый чип

Первые партии Maia 200 получила команда Microsoft, работающая над системами суперинтеллекта. Эти чипы используются для генерации данных и улучшения моделей ИИ следующего поколения.

По словам руководителя направления облачных технологий и ИИ Скотта Гатри, Maia 200 также задействуют в работе бизнес-помощника Copilot и других ИИ-моделей, включая решения OpenAI, которые Microsoft предоставляет корпоративным клиентам через Azure.

Производительность и экономия

Maia 200 производится по 3-нм техпроцессу N3P TSMC - тому же, что используется в недавно анонсированных чипах AWS Trainium 3 от Amazon. По словам старшего аналитика Freedom Finance Global Егора Толмачева, прямые сравнения «чип к чипу» не всегда показательны, однако заявленные характеристики выглядят впечатляюще.

Microsoft утверждает, что Maia 200 обеспечивает на 30 процентов лучшую производительность на доллар по сравнению с текущими решениями в собственной инфраструктуре. Это означает потенциальное снижение TCO (совокупной стоимости владения) и рост маржинальности бизнеса Azure.

Компания также заявляет о трехкратном превосходстве в FP4-производительности над Amazon Trainium третьего поколения и о преимуществе в FP8 над седьмым поколением TPU от Google.

Ставка на inference, а не обучение

Ключевой акцент Microsoft делает на том, что Maia 200 оптимизирован прежде всего под задачи inference - то есть выполнение и масштабирование уже обученных ИИ-моделей.

Это соответствует общему тренду рынка: по оценкам экспертов, 80–90 процентов ИИ-вычислений в ближайшие годы будут приходиться именно на inference, тогда как доля обучения моделей постепенно снизится. В этом контексте Maia 200 выглядит логичным инструментом для масштабирования сервисов вроде Copilot.

Память как ключевое преимущество

Отдельное внимание Microsoft уделила архитектуре памяти нового чипа. Речь идет не только об объеме и пропускной способности, но и о самой структуре.

Как отмечает Tom’s Hardware, значительная часть R&D-бюджета проекта могла быть направлена на развитие иерархии памяти, которая сочетает HBM3E и высокоэффективную SRAM-память. Это критически важно для inference-задач, где задержки и работа с памятью часто становятся узким местом.

Почему Nvidia все еще вне конкуренции

Важно отметить, что Azure Maia 200 пока доступен только для внутренних нагрузок Microsoft и работы Copilot. Массовое использование чипа внешними клиентами Azure остается под вопросом.

При этом Microsoft продолжает активно закупать GPU у Nvidia на фоне глобального дефицита дата-центров и ограниченных производственных мощностей. Более того, все сравнительные заявления гиперскейлеров сегодня делаются относительно предыдущего поколения Nvidia Blackwell, тогда как уже на подходе новая платформа Vera Rubin, обещающая кратный рост производительности.

Не «убийца Nvidia», а прагматичная стратегия

Эксперты сходятся во мнении: Maia 200 - это не попытка вытеснить Nvidia, а рациональный шаг по снижению рисков и оптимизации затрат. Nvidia по-прежнему доминирует за счет универсальности платформ, глубины экосистемы CUDA, скорости обновления поколений и лидерства в обучении моделей.

Для Microsoft собственный ИИ-чип - это способ сбалансировать инфраструктуру, сократить издержки и не зависеть полностью от одного поставщика. В этом направлении в ближайшие годы будут двигаться все крупные технологические компании.